注册扣子,复制指定智能体模板,参与抽51CTO定制鼠标垫

https://blog.51cto.com/51ctoblog/12615126

LSTM ->Long Short-Term Memory,长短时记忆神经网络,1997年提出,主要用于解决RNN没办法长时间记忆(对于很久前的信息RNN会有一种失效的问题),是一种基于RNN变化的神经网络(使得神经网络具有对很久前的信息仍有记忆效果),现广泛应用于自然语言处理(NLP),时间序列预测和构建一些高层次的模型。

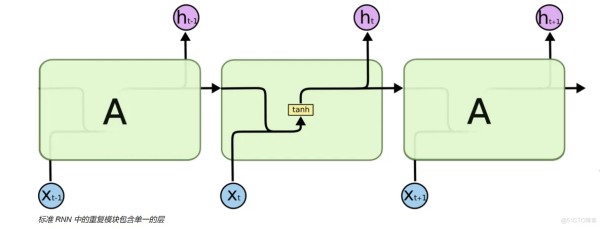

我们先透过LSTM的模型内部,去挖掘LSTM学习长期依赖信息的秘密:

首先,我们要清楚的认识到,LSTM最上面有一层细胞层Ct,是信息的载体,用于记录数据的变化:

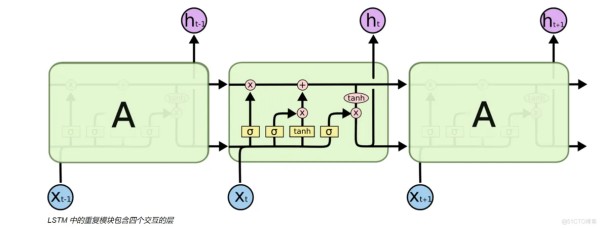

遗忘门遗忘门是LSTM模型的第一步,它接收于上一个神经元传入的信息ht-1和新传入的信息Xt,通过sigmoid函数对所有信息进行处理,得到ft传入细胞状态Ct,ft位于0-1,越接近0 -> 遗忘,越接近1 -> 记得

输入门输入门是LSTM的第二步,它把ht和xt分别用sigmoid和tanh函数进行运算,确定我们需要更新的数据。

sigmoid的用处:决定什么值要更新(筛选)

更新门是LSTM的第三步,它通过矩阵相乘和矩阵相加,把需要遗忘的数据和需要更新的数据传入细胞Ct,进行细胞状态的更新

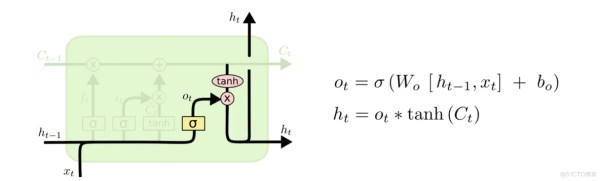

输出门

最后是输出门,通过对细胞状态Ct使用tanh函数更新出新的信息ht,输出到下一个LSTM神经元中。

sigmoid的用处:确定细胞状态Ct哪些部分输出出去(筛选)

当然这些都是我比较浅显的理解,详细可见我的参考文章理解 LSTM(Long Short-Term Memory, LSTM) 网络

关于LSTM的优缺点,可以查看这篇文章LSTM网络模型的原理和优缺点 建立LSTM ->pytorch

当然基于Tensorflow的keras里面也有直接封装好的方法:

\

注册扣子,复制指定智能体模板,参与抽51CTO定制鼠标垫

https://blog.51cto.com/51ctoblog/12615126

本文章为转载内容,我们尊重原作者对文章享有的著作权。如有内容错误或侵权问题,欢迎原作者联系我们进行内容更正或删除文章。

赞 收藏 评论 举报相关文章